La discussione relativa allo sviluppo della IA (Intelligenza Artificiale) e gli eventuali rischi per la sicurezza dell’umanità è uno dei più prolifici e interessi del momento. Il notoriamente pessimista esperto Eliezer Yudkowsky ha suggerito che l’intelligenza artificiale potrebbe distruggere il genere umano in soli due anni. Parlando al Guardian ha infatti detto:

Se mi mettessi con le spalle al muro e mi costringessi a dare probabilità alle cose, ho la sensazione che la nostra attuale linea temporale rimanente assomigli più a cinque anni che a 50 anni. Potrebbero essere due anni, potrebbero essere 10. La difficoltà è che la gente non si rende conto che abbiamo una minima possibilità che l’umanità sopravviva

Yudkowsky, che vive in California, è un ricercatore con una storia consolidata di denuncia dell’ascesa dell’intelligenza artificiale, a volte anche in modo controverso. Molti potrebbero ricordare l’anno scorso che l’esperto aveva chiesto di bombardare i data center per fermare l’ascesa dell’intelligenza artificiale. Nell’intervista al Guardian ha leggermente cambiato la la sua opinione al riguardo, anche se sostiene l’idea di bombardare i data center. Ma ora non pensa più che si debbano usare le armi nucleari per prenderli di mira.

Adesso sceglierei un fraseggio più attento – ha detto

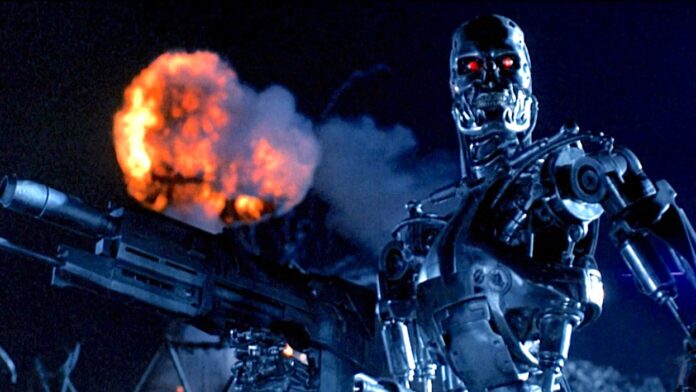

Yudkowsky ora sembra pensare che stiamo correndo verso alcuni rischi che sono stati notoriamente mostrati nei film e in TV. Ha sottolineato l’idea del punti du non ritorno in cui l’intelligenza artificiale diventa autosufficiente e decide che l’umanità non è più necessaria, sostanzialmente spazzandoci via.

La preoccupazione principale di molte persone quando si tratta dell’ascesa dell’intelligenza artificiale sia la potenziale perdita di posti di lavoro man mano che i computer diventeranno in grado di svolgere i lavori attualmente occupati dagli esseri umani. Gli esperti coinvolti nell’articolo del The Guardian si chiedono semplicemente perché le persone – e anche le aziende – potrebbero semplicemente scegliere di non perseguire l’intelligenza artificiale. Tuttavia, Yudkowsky riconosce che ciò dipenderebbe dal fatto che le aziende facciano scelte etiche.

Si potrebbe dire che a nessuno è permesso allenare qualcosa di più potente di GPT-4. L’umanità potrebbe decidere di non morire e non sarebbe così difficile

Che ne pensate?

Seguiteci su LaScimmiaPensa